Les réseaux de neurones récurrents (RNN) se font remarquer par leur talent pour gérer des infos qui se suivent. Ils sont uniques car ils ont une mémoire interne. Cette mémoire aide à garder et utiliser des infos sur le temps pour affecter les résultats. Ils deviennent donc très utiles pour des tâches où le contexte importe beaucoup, comme traduire des textes ou reconnaître ce qu’on dit.

Grâce à des boucles internes, les réseaux de neurones récurrents rnn arrivent à garder en tête des infos d’avant. Cette caractéristique les rend parfaits pour analyser des séquences de données. On les trouve souvent dans l’analyse du langage humain et dans les prévisions qui suivent le temps. Ils sont indispensables dans les métiers qui utilisent beaucoup de données, car ils rendent automatiques certains travaux et améliorent l’efficacité des entreprises.

Principaux points à retenir

- Les RNN utilisent une mémoire interne pour traiter des données séquentielles.

- Ils sont adaptés aux tâches comme la traduction automatique et la reconnaissance vocale.

- Les réseaux LSTM et GRU améliorent la gestion des dépendances à long terme.

- Les applications des RNN incluent le NLP et la prédiction des séries temporelles.

- Le deep learning est crucial pour automatiser et améliorer la productivité.

Introduction aux réseaux de neurones récurrents

Les neurones récurrents font partie des réseaux neuronaux et sont top pour gérer les données qui se suivent. Ils sont super bons pour saisir des infos qui dépendent les unes des autres. Ça les rend super importants pour comprendre la parole et travailler avec le langage naturel.

Définition et importance

Les réseaux de neurones récurrents (RNN) savent trouver des motifs dans des données qui viennent les unes après les autres. À la différence d’autres réseaux qui regardent chaque chose séparément, les RNN se rappellent ce qui s’est passé avant. Cette mémoire leur permet de piger des trucs compliqués et de donner des réponses cool.

- Les RNN sont essentiels pour bien comprendre le sens des phrases en reconnaissance vocale, pas juste les mots tout seuls.

- Ils font aussi des trucs impressionnants en deep learning, comme traduire des langues ou composer de la musique.

Comparaison avec les réseaux neuronaux traditionnels

Les réseaux neuronaux classiques, genre les perceptrons multicouches, n’ont pas de mémoire interne. Les RNN, eux, gardent en tête ce qui s’est passé pour mieux traiter les données qui se suivent. Cette différence fait que les RNN sont tops pour analyser des séquences compliquées sur le long terme.

| Aspect | Réseaux Neuronaux Traditionnels | Réseaux de Neurones Récurrents |

|---|---|---|

| Traitement des données | Indépendant | Séquentiel |

| Mémoire | Aucune | Présente |

| Applications | Classification, Reconnaissance d’image | Reconnaissance vocale, NLP |

Grâce à leur capacité à réfléchir, les RNN sont meilleurs pour gérer des suites d’événements, comme l’analyse financière ou les prévisions météo. En 2019, le deep learning a mené à des avancées majeures. Par exemple, AlphaGo a battu tous les records par sa précision et sa capacité à analyser et prédire.

Architecture des réseaux de neurones récurrents

Les réseaux de neurones récurrents (RNN) traitent bien les données qui se suivent, comme le langage ou la parole. Ils ont des couches cachées et des connexions récurrentes. Ces éléments aident à retenir des infos des données d’avant.

Composition et terminologie

La structure des RNN inclut trois parties principales :

- Les unités d’entrée, recevant les données.

- Les couches cachées, où l’info est traitée en interne.

- Les unités de sortie, présentant les résultats.

Ces éléments clés aident à saisir comment un RNN gère les données qui se suivent.

Fonctionnement des couches cachées

Les couches cachées sont vitales dans les RNN. Elles utilisent les données présentes et passées pour prévoir les futures. Ces couches permettent aux RNN de retenir temporairement des séquences d’événements. Cela améliore leur capacité à prédire.

Types de connexions récurrentes

Il y a différents types de connexions récurrentes dans les RNN :

- Boucles simples : Chaque neurone se connecte à lui-même pour s’auto-évaluer.

- Connexions de couche à couche : Les résultats d’une couche sont réutilisés dans cette même couche.

- Connexions bidirectionnelles : L’info peut aller dans les deux sens pour mieux comprendre les séquences.

Ces connexions aident les RNN à comprendre les séquences complexes dans les données.

Mécanisme d’apprentissage des RNN

Le mécanisme d’apprentissage des RNN utilise le backpropagation temporelle (BPTT). Cette méthode est essentielle pour ajuster les paramètres du réseau. Cela augmente la précision des prédictions. Les RNN ajustent leurs poids à travers le temps. Ainsi, ils comprennent mieux les séquences sur de longues durées.

Google et François Chollet ont créé TensorFlow et Keras pour ces mécanismes. Le rôle des poids est très important dans ces outils. Ajuster les poids aide le réseau à apprendre de ses erreurs. Le BPTT envoie les erreurs en arrière dans le temps, corrigeant les poids à chaque étape.

Les statistiques montrent l’impact de l’IA et du BPTT. McKinsey dit que 20 % des grandes entreprises utilisent l’IA. La banque pourrait gagner 300 milliards de dollars avec l’IA. Le commerce de détail pourrait voir 600 milliards de dollars.

Des technologies comme Theano et Caffe montrent l’importance de l’adaptation des poids. Créées par l’Université de Montréal et améliorées par Facebook, ces plateformes aident des entreprises telles qu’Airbus et IBM. Elles montrent que le BPTT fonctionne bien pour améliorer des modèles.

Les algorithmes d’apprentissage et le BPTT sont clés pour améliorer les RNN. Grâce à des techniques spécifiques et l’ajustement des poids, les modèles deviennent plus précis et efficaces. Cela a un grand impact sur l’industrie.

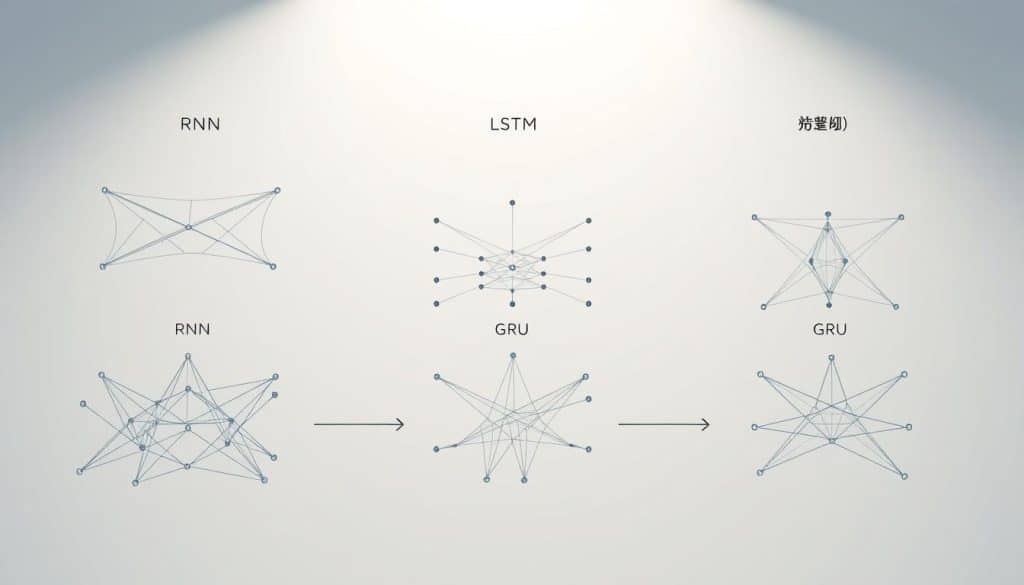

Types de réseaux de neurones récurrents

Les modèles de réseaux de neurones récurrents sont essentiels. Ils ont des caractéristiques uniques et sont utilisés pour diverses tâches. Il existe plusieurs types principaux : RNN standard, LSTM, GRU et RNN bidirectionnels.

RNN standard

Le RNN standard est le type de base. Il traite les données une par une. Mais, il a des problèmes avec les longues séquences.

Long Short-Term Memory (LSTM)

Les Long Short-Term Memory (LSTM) règlent les problèmes des RNN standards. Ils gardent des informations plus longtemps. C’est utile pour des tâches comme comprendre la parole et le langage.

Gated Recurrent Units (GRU)

Les GRU sont une version simplifiée des LSTM. Ils sont presque aussi bons, mais plus faciles à calculer. Ils aident à garder en mémoire des informations sur des périodes courtes.

RNN bidirectionnels

Les RNN bidirectionnels analysent les données dans deux directions. Cela leur permet de mieux comprendre le contexte. Ils sont parfaits pour traduire des langues et comprendre le sens complet d’un texte.

| Type | Caractéristiques | Applications typiques |

|---|---|---|

| RNN standard | Sujet à la disparition des gradients | Analyse séquentielle simple |

| LSTM | Mécanismes de mémoire à long terme | Reconnaissance vocale, NLP |

| GRU | Similaire aux LSTM mais plus simple | Problèmes de mémoire courte |

| RNN bidirectionnels | Traitement dans les deux sens temporels | Traduction automatique, compréhension contextuelle |

Applications des réseaux de neurones récurrents

Les réseaux de neurones récurrents (RNN) changent la donne dans plusieurs domaines. Leur habileté particulière à traiter les données séquentielles les rend précieux. Ils aident à améliorer notre quotidien et à rendre les entreprises plus efficaces.

Reconnaissance vocale

La reconnaissance vocale est une des plus grandes réussites des RNN. Grâce à eux, on peut transformer notre parole en texte. Cela ouvre la voie à des technologies comme Siri d’Apple et Google Assistant. Ces outils comprennent le contexte des mots et rendent nos conversations avec les machines plus simples.

Traitement automatique du langage naturel (NLP)

Le NLP profite aussi beaucoup des RNN. Ils sont au cœur de la traduction automatique et de la création de texte. Par exemple, Google Translate et GPT-3 montrent bien leur importance. Ils savent tirer sens et structure de vastes ensembles de données textuelles.

Prévision des séries temporelles

Les RNN excellent également dans la prévision des séries temporelles. Ils examinent des données comme les tendances boursières ou la météo pour prédire l’avenir. Les banques et météorologues les utilisent pour faire des prévisions fiables. Cela aide à prendre de meilleures décisions financières ou à prévoir le climat plus précisément.

| Application | Utilisation | Exemples concrets |

|---|---|---|

| Reconnaissance vocale | Conversion de la parole en texte | Siri, Google Assistant |

| NLP | Traduction automatique, génération de texte | Google Translate, GPT-3 |

| Prévision temporelle | Prévisions financières, météorologiques | Analyse de tendances de marché, prévisions climatiques |

En résumé, les RNN ont un rôle clé dans la reconnaissance vocale, le NLP et les prévisions temporelles. Ils montrent comment l’IA peut nous aider à surmonter des défis complexes par l’analyse de données séquentielles.

Défis et limitations des RNN

Les réseaux de neurones récurrents (RNN) sont très puissants. Mais, ils font face à des défis qui compliquent leur utilisation. Leurs principaux problèmes incluent la disparition de gradient, l’explosion de gradient, et la mémoire courte.

Disparition et explosion des gradients

Les gradients des erreurs dans les RNN peuvent devenir soit trop petits soit trop grands. Un gradient trop petit signifie une disparition de gradient, rendant l’apprentissage très lent. À l’inverse, un gradient trop grand peut causer une explosion de gradient. Ceci peut rendre difficile pour le réseau d’apprendre correctement.

Imaginons un modèle de vidéo comme Runway Gen-3 Alpha sans bonne gestion des explosions de gradient. La qualité des vidéos générées baisserait, affectant ainsi l’efficacité de la génération de vidéo.

Problèmes de mémoire courte

Les RNN standards luttent souvent pour retenir des informations à long terme. C’est le problème de mémoire courte. Ça peut être un obstacle pour des tâches comme la reconnaissance vocale ou le NLP. Des solutions comme les LSTM et les GRU aident à gérer les informations sur le long terme.

Quand Google sortira Lumiere en 2024, l’usage de LSTM et GRU aidera à maintenir la qualité des vidéos. Cela permettra de gérer de longues séquences sans perdre d’informations importantes.

Les défis des RNN soulignent l’importance de comprendre leurs limites pour améliorer les performances de l’IA.

Conclusion

Les réseaux de neurones récurrents (RNN) marquent une grande avancée dans le traitement des données qui se suivent. Ils changent la façon dont on comprend l’apprentissage automatique et l’intelligence artificielle (IA). Grâce aux architectures comme les LSTM et GRU, ils améliorent la gestion des problèmes liés à la mémoire et aux gradients.

Les RNN sont utiles dans beaucoup de domaines. Par exemple, ils aident dans la reconnaissance vocale avec des assistants virtuels comme Siri et Alexa. Ils sont aussi importants pour traiter le langage naturel et prévoir les séquences de données dans le temps. Ces technologies rendent nos interactions avec les machines plus intelligentes et plus naturelles.

Le monde crée énormément de données tous les jours, environ 2,5 millions de téraoctets. Les RNN, qui s’inspirent de notre cerveau, utilisent ces données pour s’améliorer. De plus, l’apprentissage sur la Data Science aide beaucoup de professionnels à s’y connaître dans ce domaine. Cela mène à des innovations continues. En résumé, les RNN promettent un futur plein de progrès grâce à l’IA, plus efficace et plus présente dans nos vie.