Long Short-Term Memory (LSTM) est un type spécial de réseau de neurones. Il a été créé pour pallier les faiblesses des RNN standards, comme le souci des gradients qui s’estompent. Les LSTM, à la différence des RNN simples, apprennent mieux les liens à long terme. Ils sont super utiles pour comprendre le langage humain et prévoir les événements futurs. Ce guide va vous plonger dans le monde des LSTM, vous montrer comment ils marchent, leur structure unique, et pourquoi ils sont importants dans l’intelligence artificielle.

Points Clés

- Les LSTM sont faits pour apprendre les connexions à long terme dans les données.

- Ils viennent à bout du problème des gradients qui disparaissent, un défaut des RNN classiques.

- On les utilise beaucoup pour créer des modèles de langage, reconnaître la parole, et prévoir les tendances.

- Leur structure complexe inclut des portes spéciales qui aident à gérer les informations de manière efficace.

- Les LSTM nécessitent pas mal de mémoire pour conserver certaines données essentielles.

- Comme ils sont plus sophistiqués, former des LSTM prend plus de temps que les RNN standards.

- Cependant, leur conception permet une parallélisation qui peut accélérer leur apprentissage.

Qu’est-ce que LSTM ?

Le terme LSTM est l’abréviation de Long Short-Term Memory. Il marque une avancée importante dans le domaine des réseaux neuronaux récurrents. Cette technologie aide à surmonter les problèmes des dépendances à long terme qui dérangent souvent les réseaux traditionnels.

Sepp Hochreiter et Jürgen Schmidhuber ont créé les LSTM en 1997. Ils ont changé la façon dont les machines gèrent les séquences de données. Grâce aux LSTM, les machines peuvent maintenant retenir des informations importantes pendant longtemps. Cela a transcendé les limites des modèles plus anciens.

La force des LSTM réside dans leurs cellules de mémoire spéciales. Ces cellules aident à maintenir et manipuler l’état interne, rendant les modèles plus efficaces pour les tâches séquentielles. Avant d’explorer l’architecture des LSTM, il est essentiel de saisir leur impact sur l’intelligence artificielle.

L’emploi des LSTM est devenu populaire en 2016 avec l’avènement du Deep Learning pour traiter le texte. Ils sont centraux dans de nouvelles architectures comme GPT-2 et GPT-3. Par exemple, GPT-1 avait 100 millions de paramètres. En 2020, GPT-3 en a 20 milliards, montrant une croissance rapide dans le traitement des données.

DistillBERT, lancé par Hugging Face en 2019, a 66 millions de paramètres. Cette évolution prouve que cette technologie s’est bien développée. De plus, elle est de plus en plus accessible. Les modèles BERT de Google et les architectures LSTM excellent souvent au-delà des capacités humaines, selon le Benchmark GLUE.

Les LSTM sont cruciaux dans le traitement automatique du langage naturel (NLP), pour des usages comme la reconnaissance vocale et la traduction automatique. Leur fiabilité et polyvalence en font un pilier essentiel pour les technologies présentes et futures.

Architecture de LSTM

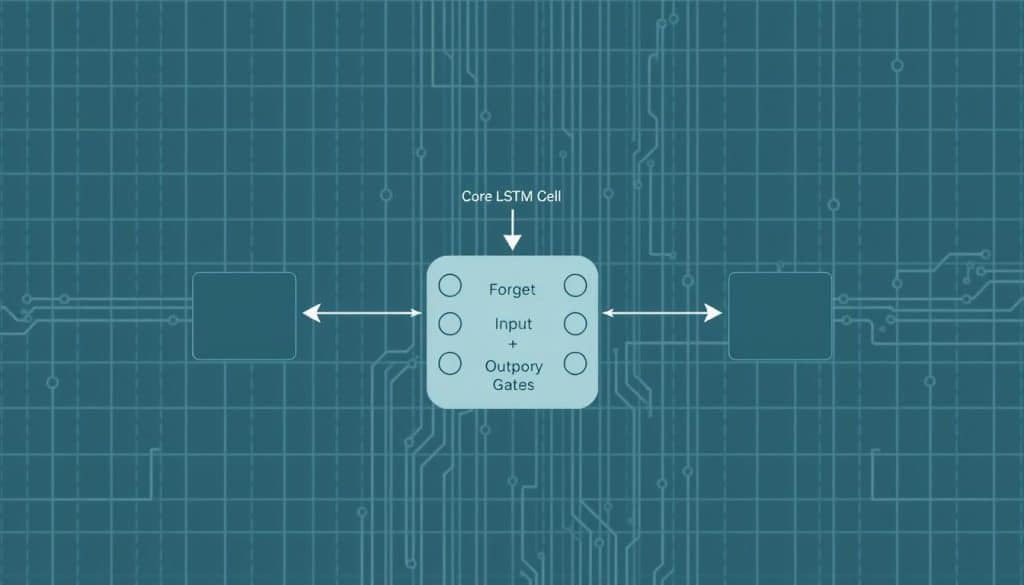

L’architecture des LSTMs se base sur un principe clé : les cellules LSTM. Ces cellules gèrent le flux d’informations au moyen de trois portes de la mémoire LSTM importantes. On a la porte d’oubli, la porte d’entrée et la porte de sortie. Les fonctions d’activation sigmoïdales permettent à ces portes de fonctionner de manière optimale.

Ces composantes LSTM jouent un rôle crucial. Elles préservent les informations essentielles sur le long terme. En même temps, elles préviennent les problèmes de gradient explosif ou disparu.

- Porte d’oubli: Décide des informations à garder ou à effacer. Un score près de 0 signifie oublier, près de 1 signifie conserver.

- Porte d’entrée: Juge l’importance des nouvelles infos. Une note près de 0 indique peu d’importance, proche de 1 indique beaucoup d’importance.

- Porte de sortie: Gère combien d’infos vont vers l’état caché suivant. oₜ proche de 0, peu transmis ; proche de 1, beaucoup est transmis.

Grâce à cette structure avancée, l’architecture des LSTMs surpasse les limites des RNN traditionnels. Cela concerne surtout la gestion des dépendances à long terme. Les cellules LSTM et leurs portes complexes aident à relever divers défis. Ces défis incluent la prévision de séries temporelles, l’analyse de sentiments et la traduction automatique.

Pour conclure, les LSTMs sont très utilisés dans la gestion du langage naturel et d’autres domaines. Ces domaines incluent la reconnaissance vocale et la prédiction temporelle. Leur habileté à manipuler de longues séquences de données les rend indispensables pour diverses applications complexes.

Fonctionnement de LSTM

Les réseaux de neurones LSTM sont faits pour comprendre les liens à long terme dans les données. Ils sont utiles pour des choses difficiles comme traduire des textes, reconnaître la parole et prévoir le futur des données.

Contrairement aux RNN qui peinent avec les liens à long terme à cause des gradients qui disparaissent, les LSTM apportent des solutions élaborées. Les RNN normaux ont du mal quand les gradients explosent, ce qui les rend instables pendant l’entraînement. Mais les LSTM, avec leurs portes spéciales, évitent ces problèmes.

Le processus LSTM utilise trois portes importantes : l’entrée, l’oubli, et la sortie. Ces portes gèrent l’information dans la cellule de mémoire. La porte d’oubli choisi si une info est gardée ou supprimée, donnant un résultat binaire (0 ou 1). La porte d’entrée crée un vecteur candidat avec la fonction tanh, faisant des sorties entre -1 et +1.

La porte de sortie décide de l’information à utiliser, en fonction de l’état caché et de l’entrée, utilisant aussi tanh.

Un trait unique des réseaux de neurones LSTM c’est qu’ils peuvent être empilés. Cela leur permet d’apprendre des motifs plus complexes. Aussi, les LSTM bidirectionnels traitent les données dans les deux directions. Cela aide à mieux apprendre des liens à long terme que les LSTM normaux.

L’architecture avancée des LSTM aide à gérer les données séquentielles en mettant en place des unités de mémoire spéciales. Cela permet d’apprendre des liens à long terme difficiles à saisir pour les RNN. Les LSTM excellent dans des tâches comme le résumé de texte, la détection d’anomalies, et les recommandations.

Applications et avantages des Long Short-Term Memory

Les applications LSTM sont nombreuses et montrent leur utilité dans beaucoup de domaines. Ils sont parfaits pour trouver des motifs compliqués dans les données qui changent avec le temps. Par exemple, ils excellent en reconnaissance vocale, en prédiction de données temporelles et en traitement de la langue.

Le modèle Alpha Go de Google en est un exemple frappant. En 2016, ce modèle a défié et battu les champions du jeu de Go, prouvant l’efficacité des LSTM en Deep Learning.

Les avantages LSTM sont particulièrement remarquables face aux méthodes plus anciennes. Ils ne perdent pas et n’explosent pas l’information comme d’autres systèmes pourraient le faire. Grâce à leur capacité de se rappeler des infos importantes sur le long terme, ils sont précieux pour prédire les séquences de données au fil du temps et améliorer la reconnaissance vocale.

Dans le monde industriel, Amazon et Netflix utilisent ces technologies pour proposer des recommandations sur mesure. En analysant les données des clients, ils arrivent à offrir des suggestions qui captivent plus d’utilisateurs.

Les usages des LSTM vont de la finance, pour la prédiction des marchés boursiers, jusqu’à la santé, pour l’analyse de données de patients sur le temps. Les LSTM restent essentiels pour les scientifiques et développeurs désirant créer des modèles fiables et précis.

Comparaison avec RNN

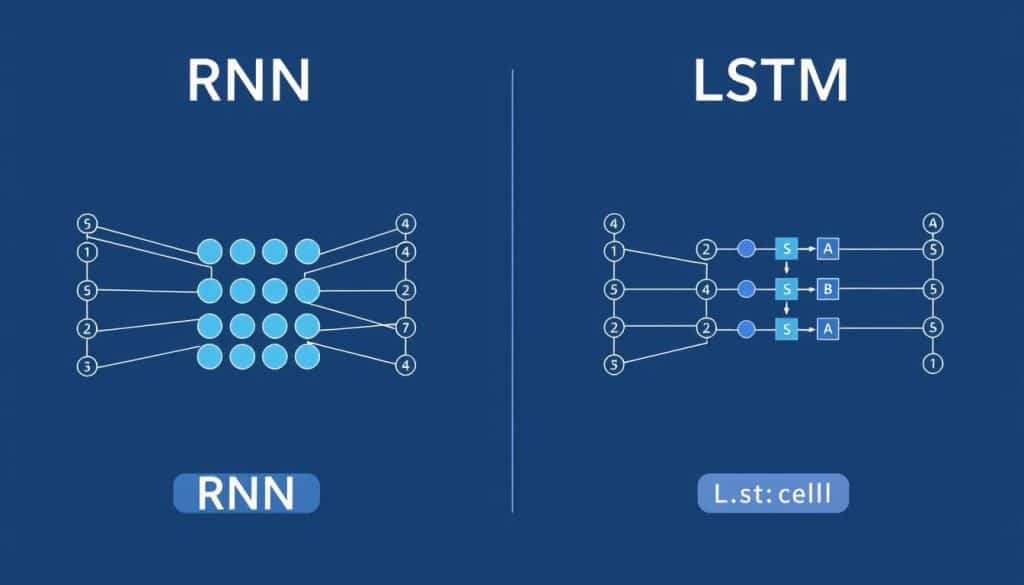

Abordons la comparaison LSTM RNN. Les différences LSTM RNN sont essentielles pour saisir leur efficacité. Les réseaux neuronaux récurrents (RNN) traitent des suites de données. Mais, ils rencontrent un gros souci : le problème du gradient qui disparaît. Cela limite leur aptitude à comprendre des liaisons sur la longue durée.

En contraste, les LSTM (Long Short-Term Memory) triomphent de ce problème grâce à leur structure unique. Elle inclut des portes pour bien gérer les infos à court et long terme. Cette technique rend les LSTM bien plus efficients que les RNN classiques.

Regardons une table de comparaison:

| Critère | RNN traditionnel | LSTM |

|---|---|---|

| Gestion des dépendances à long terme | Limitée par le problème du gradient qui disparaît | Excellente grâce aux mécanismes de portes |

| Complexité de l’architecture | Simpler | Plus complexe avec des cellules mémoire |

| Applications | Moins adaptées pour les longues séquences | Idéales pour des tâches avec longue séquence comme la traduction et la reconnaissance vocale |

| Illustration 1: Comparaison des performances entre les LSTM et les RNN | ||

En résumé, comparer les LSTM et les RNN montre que les LSTM excellent là où les RNN échouent. Ils sont mieux pour gérer les liens sur la durée. Les LSTM surpassent donc les RNN dans des domaines comme la création de texte et la reconnaissance vocale.

Conclusion

Les réseaux Long short-term memory (LSTM) ont prouvé qu’ils sont meilleurs que les réseaux de neurones traditionnels. Ils apprennent mieux les informations qui durent longtemps grâce à une structure spécifique. Cette structure inclut une cellule mémoire et trois portes qui aident à éviter les problèmes communs des réseaux traditionnels. Ainsi, les LSTM gardent des infos importantes sur de longues périodes, ce qui améliore leur efficacité.

Ils sont très utiles dans plusieurs domaines comme la reconnaissance de parole et la traduction automatique. Leur capacité à analyser les sentiments montre aussi leur polyvalence. Les variations de ces réseaux, comme les LSTM bidirectionnels, apportent encore plus d’avantages. Ils améliorent la compréhension du contexte sans rendre les calculs trop complexes.

En bref, les LSTM marquent un grand pas en avant par rapport aux réseaux traditionnels. Ils sont prometteurs pour l’avenir, surtout dans des secteurs comme la finance et la météorologie. Grâce à leur innovation constante, ils vont continuer à rendre les algorithmes plus efficaces. Les recherches et l’utilisation des LSTM annoncent un avenir lumineux pour cette technologie en pleine expansion.