L’intelligence artificielle avance vite. Les modèles multimodaux jouent un rôle clé dans cette évolution. Ils peuvent traiter plusieurs types de données à la fois, comme le texte, les images, l’audio et la vidéo.

Grâce à cette capacité, les modèles multimodaux donnent des résultats plus pertinents. Cela ouvre la porte à de nouvelles applications. Dans cet article, nous allons voir comment ces modèles fonctionnent, les comparer aux autres et montrer leurs avantages dans différents domaines.

Points clés à retenir

- Les LMM traitent simultanément plusieurs types de données, offrant des résultats plus contextuels.

- Ils se distinguent des modèles traditionnels et des LLM par leur capacité à gérer des données multimodales.

- Les LMM ouvrent la voie à des applications innovantes dans divers secteurs.

- Leur fonctionnement implique des modules d’entrée, de fusion et de sortie pour traiter les différentes modalités.

- Malgré les défis liés à la formation et à l’implémentation, les LMM offrent des avantages significatifs par rapport aux modèles traditionnels.

Introduction aux modèles multimodaux

Les modèles multimodaux sont une grande avancée dans l’intelligence artificielle. Ils peuvent traiter plusieurs types de données à la fois. Cela inclut le texte, les images et l’audio.

Qu’est-ce qu’un modèle multimodal ?

Un modèle multimodal est un système IA qui gère plusieurs types de données. Il diffère des modèles unimodaux, qui ne traitent qu’une seule modalité. Les modèles multimodaux combinent des informations de différentes sources.

Cela permet de mieux comprendre le contenu. Par exemple, un modèle peut analyser le texte et les images d’un article. Ainsi, il saisit le sens global et les détails spécifiques.

Différences entre les modèles multimodaux et les modèles traditionnels

Les modèles multimodaux sont plus polyvalents que les modèles traditionnels. Ils peuvent traiter des données variées. Les systèmes classiques se limitent à une tâche spécifique.

La flexibilité des modèles multimodaux ouvre de nouvelles possibilités. Ils peuvent générer des légendes pour des images ou résumer des vidéos. Ils offrent des résultats plus précis, se rapprochant de la compréhension humaine.

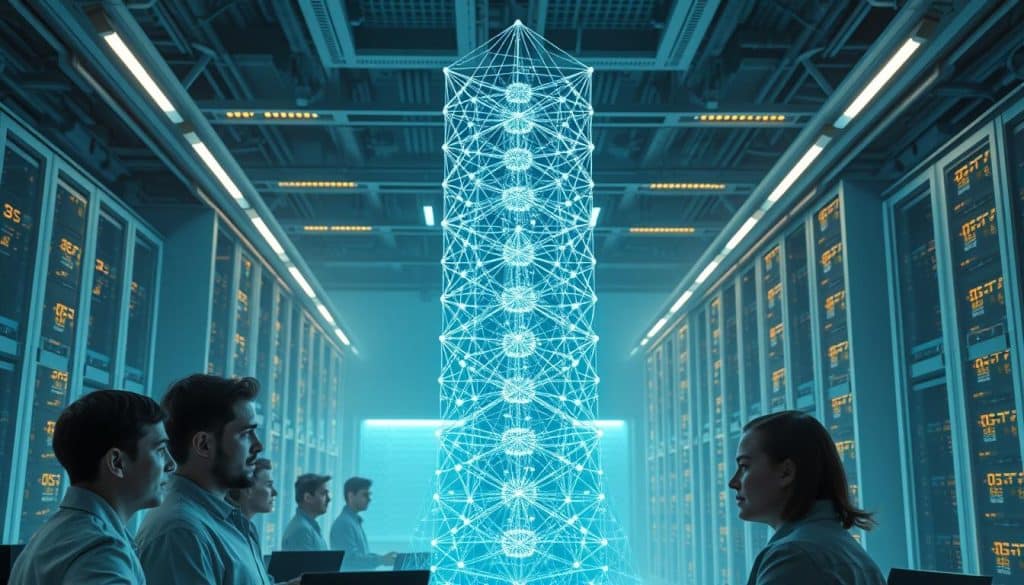

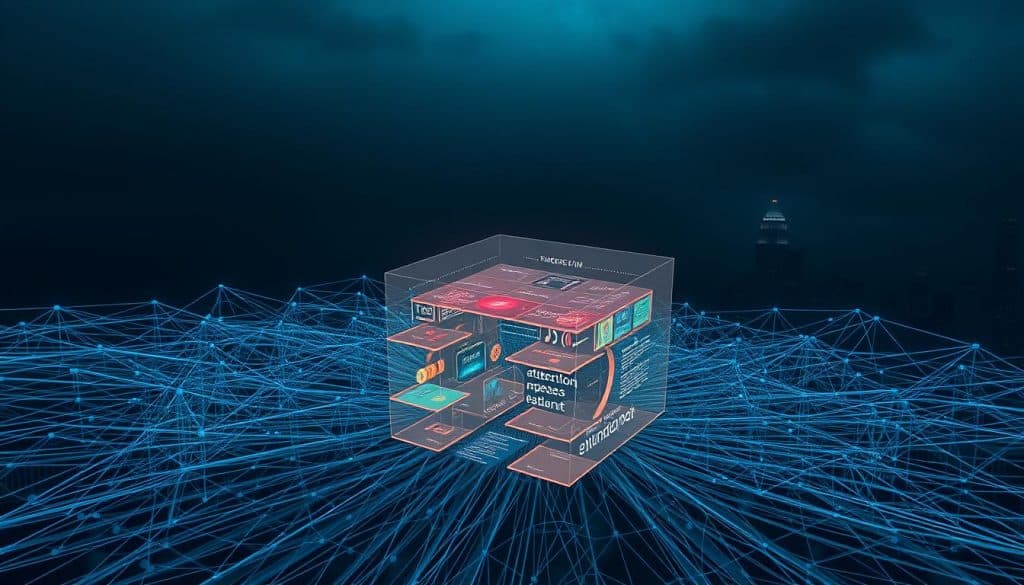

Comment fonctionnent les modèles multimodaux

Les modèles multimodaux, comme les grands modèles multimodaux (LMM), ont une structure unique. Ils traitent différents types de données efficacement. Cette structure comprend des modules d’entrée, de fusion et de sortie. Chacun a un rôle clé dans le traitement des données.

Modules d’entrée pour gérer différentes modalités

Les modules d’entrée traitent chaque type de données séparément. Par exemple, le texte est analysé par des techniques de NLP. Les images sont traitées par des CNN, et l’audio par des RNN ou des transformeurs. Cette méthode optimise la gestion des données.

Modules de fusion pour combiner les représentations

Après le traitement des données par les modules d’entrée, elles sont fusionnées. Un module de fusion crée une représentation unifiée des données. Cette étape permet de comprendre le contenu global. Les techniques de fusion varient mais visent à créer une représentation cohérente des données.

| Modèle | Paramètres | Précision GenEval | Précision DPG-Bench | Score MMBench |

|---|---|---|---|---|

| Janus-Pro-7B | 7 milliards | 80% | 84,19% | 79,2 |

| DALL-E 3 | – | 67% | – | – |

| Stable Diffusion 3 | – | 74% | – | – |

| GPT-4V | – | – | – |

Modules de sortie pour générer des résultats

Le module de sortie utilise la représentation fusionnée pour produire des résultats. Il peut créer du texte, des images, ou des actions. La qualité des résultats dépend de la capacité du modèle à traiter les informations.

Comparaison entre les grands modèles de langage (LLM) et les grands modèles multimodaux (LMM)

Les grands modèles de langage (LLM) et les grands modèles multimodaux (LMM) sont deux types d’intelligence artificielle. Les LLM, comme GPT-4, se focalisent sur le traitement du texte. En revanche, les LMM, comme Vision GPT-4, gèrent des données textuelles, visuelles, audio et vidéo.

La capacité multimodale des LMM permet de combiner différents types de données. Par exemple, texte et images pour une meilleure compréhension. Ils ont des applications variées, comme le sous-titrage automatique de vidéos éducatives ou l’analyse d’images médicales.

| Caractéristique | LLM (ex: GPT-4) | LMM (ex: Vision GPT-4) |

|---|---|---|

| Modalités supportées | Texte uniquement | Texte, images, audio, vidéo |

| Compétences générées | Rédaction, résumé, traduction | Sous-titrage, analyse vidéo, chatbots multimodaux |

| Domaines d’applications | Traitement automatique du langage | Santé, éducation, service client, divertissement |

La formation des LMM soulève des défis liés à la complexité des données multimodales. Intégrer et optimiser les différentes modalités est crucial pour leurs performances.

En résumé, les LLM sont excellents pour les tâches linguistiques. Mais les LMM offrent une nouvelle dimension en combinant texte, image, son et vidéo. Cela ouvre de nouvelles perspectives dans de nombreux secteurs, de la santé à l’éducation et au divertissement.

Applications des modèles multimodaux

Les modèles multimodaux (LMM) changent beaucoup de domaines. Ils peuvent traiter plusieurs types de données à la fois. Ils sont utilisés dans la santé, l’éducation, le service client et plus encore. Voyons quelques exemples intéressants.

Santé et analyse d’images médicales

Dans la santé, les LMM apportent de nouvelles idées pour l’imagerie médicale. Ils combinent l’analyse d’images avec les données des patients. Cela donne des résultats plus précis et adaptés à chaque personne.

Éducation et apprentissage interactif

L’éducation profite aussi des LMM grâce à l’apprentissage interactif multimodal. Ils mélangent texte, images et audio pour une expérience d’apprentissage plus immersive. Les étudiants apprennent mieux de façon ludique et interactive.

Service client et chatbots intelligents

Les LMM changent le service client avec des chatbots IA qui comprennent texte et images. Ces interactions sont plus naturelles et efficaces. Cela rend les clients plus satisfaits et diminue le travail des agents.

| Modèle | Cas d’usage | Performance |

|---|---|---|

| Pixtral | Extraction d’informations à partir de flyers | Meilleure qualité de traitement comparé à Llama 3.2 et Qwen2-VL |

| Whisper | Reconnaissance vocale multilingue open source | Haute précision pour la transcription audio |

| Mistral Moderation | Filtrage de contenu inapproprié pour la modération automatique | Efficace pour maintenir des espaces en ligne sains |

Divertissement et sous-titrage automatique

Dans le divertissement, les LMM changent le sous-titrage automatique des films et émissions TV. Ils analysent l’audio, les images et le contexte pour des sous-titres précis. Cela rend le contenu accessible à plus de gens, y compris ceux malentendants ou parlant d’autres langues.

Ces exemples montrent à peine ce que les modèles multimodaux peuvent faire. Ils peuvent traiter et lier différentes données. Les LMM ouvrent de nouvelles voies passionnantes dans de nombreux domaines, poussant les limites de l’intelligence artificielle.

Défis de la formation des modèles multimodaux

Former des modèles multimodaux est un grand défi pour les entreprises. Ils ont besoin de données multimodales vastes et variées. Ces données sont difficiles à gérer et à aligner.

En 2025, 70% des entreprises devront améliorer leur gestion des données. Cela est crucial pour surmonter les défis des données multimodales complexes.

Optimisation des méthodes d’entraînement

Optimiser les méthodes d’entraînement est un autre grand défi. Les coûts opérationnels augmentent, ainsi que l’empreinte carbone. 90% des entreprises veulent rendre l’IA plus accessible tout en utilisant moins de ressources.

Il faut donc développer des méthodes d’entraînement innovantes. Ces méthodes doivent réduire la fonction de perte sur toutes les modalités.

Intégration des mécanismes attentionnels

L’intégration des mécanismes attentionnels est essentielle. Ces mécanismes permettent au modèle de se concentrer sur les informations importantes. Ils améliorent la capacité du modèle à traiter les données multimodales.

Mais, leur mise en œuvre nécessite une expertise et des infrastructures solides. Cela peut être un défi pour de nombreuses entreprises.

Création d’incorporations multimodales

Créer des incorporations multimodales est un enjeu majeur. Ces incorporations permettent de fusionner les différentes modalités. Elles facilitent le traitement des données multimodales par le modèle.

La création d’incorporations efficaces nécessite des approches innovantes. Cela peut être un défi pour les entreprises.

Surmonter les défis de l’implémentation des modèles multimodaux

L’utilisation des modèles multimodaux (LMM) dans les applications pose des problèmes. La principale difficulté est de combiner des données de différents types. Par exemple, textes, images, sons et vidéos doivent être fusionnés efficacement.

Les coûts pour former ces modèles sont élevés. Ils nécessitent beaucoup de données et de puissance de calcul. Selon une étude, former un modèle d’IA génératif coûte environ 900 000 euros. Cela montre l’importance de trouver des moyens pour réduire ces coûts.

Comprendre les décisions des modèles multimodaux est un autre défi. Ces modèles complexes rendent difficile la compréhension de leurs actions. Près de 40% des projets d’IA générative rencontrent des problèmes éthiques, selon une étude. Il est donc crucial de développer des méthodes pour expliquer ces modèles.

La scalabilité des modèles multimodaux est un autre problème technique. Pour les utiliser à grande échelle, il faut une infrastructure solide. Cette infrastructure doit gérer les données multimodales et fournir des résultats rapidement.

Malgré ces défis, des progrès sont faits pour faciliter l’utilisation des modèles multimodaux. Les avancées dans les architectures et l’optimisation des calculs sont prometteuses. Elles ouvrent la voie à des applications innovantes dans de nombreux domaines.

Conclusion

Les grands modèles multimodaux (LMM) marquent un grand pas en avant dans l’intelligence artificielle. Ils combinent des données textuelles, visuelles, audio et vidéo de manière innovante. Ces LMM ont de grandes applications dans la santé, l’éducation, le service client et le divertissement.

Par exemple, ils peuvent analyser des images médicales, créer des expériences d’apprentissage interactives, développer des chatbots intelligents ou automatiser le sous-titrage. Les perspectives ouvertes par les LMM sont vastes et passionnantes.

Pour exploiter pleinement le potentiel des LMM, il faut encore relever des défis techniques. La complexité des données multimodales, l’optimisation des méthodes d’entraînement et l’intégration des mécanismes attentionnels sont des enjeux majeurs. La création de données multimodales de qualité est essentielle pour le succès des entreprises.

En résumé, l’avenir de l’IA est multimodale. Les progrès récents, comme ceux de Kosmos-1, Flamingo, LLaVA et PaLM-E, montrent une accélération de l’innovation. Avec le temps, les LMM révolutionneront de nombreux secteurs et transformeront notre rapport à la technologie. L’ère de l’IA multimodale est excitante.